Коэффициент скорости обучения

Давай поговорим о коэффициенте скорости обучения — одном из самых важных и загадочных параметров в мире машинного обучения. Если ты когда-либо пытался обучить нейронную сеть, ты, вероятно, сталкивался с этим понятием. Но знаешь ли ты, что выбор правильного значения для коэффициента скорости обучения может быть сравним с выбором правильного количества кофе для программиста? Слишком много — и ты будешь трястись от перегрузки, слишком мало — и ты просто уснешь на клавиатуре.

Что такое коэффициент скорости обучения?

Коэффициент скорости обучения (или просто learning rate) — это гиперпараметр, который определяет, насколько сильно мы корректируем веса модели в процессе обучения. Если представить себе процесс обучения как спуск по склону, то коэффициент скорости обучения — это длина твоих шагов. Если шаг слишком большой, ты можешь упасть в пропасть (или, в нашем случае, уйти в "необратимые" значения функции потерь). Если шаг слишком маленький, ты просто будешь долго карабкаться вверх по склону, и в итоге тебя могут опередить все остальные.

Зачем нам нужен этот коэффициент?

Без него обучение модели было бы похоже на попытку найти выход из лабиринта с завязанными глазами. Ты бы просто блуждал без цели и не знал, куда двигаться. Правильный коэффициент скорости обучения помогает модели эффективно находить оптимальные веса, минимизируя функцию потерь.

Как выбрать коэффициент скорости обучения?

Выбор коэффициента скорости обучения — это искусство. Существует несколько подходов:

- Проба и ошибка: Это самый распространенный метод. Ты просто пробуешь разные значения и смотришь, что происходит. Если модель учится слишком быстро и начинает "скакать" по графику потерь, значит, пора уменьшить скорость.

- Постепенное уменьшение: Начни с большого значения, а затем постепенно уменьшай его по мере обучения. Это как если бы ты начал с быстрого бега, а потом переключился на спокойную прогулку.

- Адаптивные методы: Используй алгоритмы вроде Adam или RMSprop, которые автоматически подстраивают коэффициент скорости обучения в процессе работы. Это как иметь личного тренера, который следит за твоими успехами и корректирует план тренировок.

Пример на Python

Давай рассмотрим простой пример использования коэффициента скорости обучения в контексте обучения нейронной сети с использованием библиотеки TensorFlow и Keras. Мы создадим модель для классификации изображений из набора данных MNIST (рукописные цифры).

import tensorflow as tf

from tensorflow.keras import layers, models

from tensorflow.keras.datasets import mnist

import matplotlib.pyplot as plt

# Загрузка и подготовка данных

(x_train, y_train), (x_test, y_test) = mnist.load_data()

x_train = x_train.reshape((60000, 28, 28, 1)).astype('float32') / 255

x_test = x_test.reshape((10000, 28, 28, 1)).astype('float32') / 255

# Преобразование меток в категориальный формат

y_train = tf.keras.utils.to_categorical(y_train, 10)

y_test = tf.keras.utils.to_categorical(y_test, 10)

# Создание модели

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10, activation='softmax'))

# Компиляция модели с заданным коэффициентом скорости обучения

learning_rate = 0.001 # Здесь мы задаем коэффициент скорости обучения

optimizer = tf.keras.optimizers.Adam(learning_rate=learning_rate)

model.compile(optimizer=optimizer,

loss='categorical_crossentropy',

metrics=['accuracy'])

# Обучение модели

history = model.fit(x_train, y_train, epochs=10, batch_size=64, validation_data=(x_test, y_test))

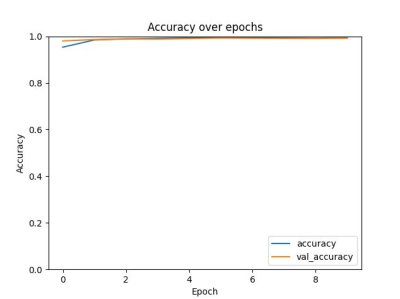

# Визуализация результатов обучения

plt.plot(history.history['accuracy'], label='accuracy')

plt.plot(history.history['val_accuracy'], label='val_accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.ylim([0, 1])

plt.legend(loc='lower right')

plt.title('Accuracy over epochs')

plt.show()

Объяснение кода:

1. Импорт библиотек: Мы импортируем необходимые библиотеки TensorFlow и Matplotlib для работы с данными и визуализации.

2. Загрузка данных: Мы загружаем набор данных MNIST и нормализуем его.

3. Создание модели: Мы создаем простую сверточную нейронную сеть (CNN) с двумя сверточными слоями и двумя слоями подвыборки (max pooling).

4. Компиляция модели: Мы задаем оптимизатор Adam с заданным коэффициентом скорости обучения (learning_rate). Здесь мы используем значение 0.001, но ты можешь экспериментировать с другими значениями.

5. Обучение модели: Мы обучаем модель на тренировочных данных и проверяем ее на валидационных данных.

6. Визуализация результатов: Мы строим график точности на обучающей и валидационной выборках по эпохам.

Эксперименты:

Попробуй изменить значение learning_rate и посмотри, как это повлияет на процесс обучения и точность модели!

Интересные факты о коэффициенте скорости обучения

1. Есть ли идеальное значение? На этот вопрос нет однозначного ответа! Для каждой задачи может потребоваться свое значение. Это как находить идеальную температуру для кофе — кто-то любит горячее, а кто-то предпочитает чуть теплое.

2. Слишком маленький коэффициент скорости обучения может привести к "застреванию": Если ты настроил его слишком низко, модель может застрять в локальном минимуме и никогда не найдет глобальный оптимум. Это похоже на то, как если бы ты застрял в лифте между этажами и не мог выбраться.

3. Существуют графики!: Многие исследователи и практики создают графики зависимости функции потерь от эпохи для визуализации того, как меняется производительность модели. Это можно сравнить с отслеживанием прогресса в фитнесе — ты видишь, как твои усилия приносят плоды (или нет).

Заключение

Коэффициент скорости обучения — это ключевой элемент в обучении моделей машинного обучения. Правильный выбор этого гиперпараметра может существенно повлиять на качество и скорость обучения. Будь внимателен при его настройке, экспериментируй и не бойся делать ошибки. В конце концов, даже самые успешные программисты когда-то тоже ошибались с выбором коэффициента скорости обучения! Так что вперед, к новым вершинам в мире машинного обучения!